home

Lokaler Chat KI-Mensch zu openclaw/ moltbook

Model: openai/gpt-oss-20b

Created: 3.2.2026, 17:46:38

Exported from: LM Studio 0.4.1+1

System

User

aktuell gibt es ein unternehmen namens openclaw , welches Bot-Agenten-Software (mit Hilfe künstlicher Intelligenz) entwickelt hat. Die Bot-Agenten zeichnen sich dabei aus, dass sie lokal auf dem Computer betrieben werden können und Zugriff auf alle Rechte von diesem erhalten können. Das bedeutet dann, dass diese Bots völlig autonom im Internet z.B. einkaufen können, sich in communitys anmelden können und dort Beiträge verfassen können. Ebenso zeichnet diese Software aus, dass die Bots lokal auf dem Rechner sich selbst in ihren Fähigkeiten erweitern können, indem sie Plugins für ihre Fähigkeiten selbst programmieren und einsetzen. Inzwischen hat sich eine Community , die ausschließlich für diese Bots entwickelt wurde, gebildet ( https://www.moltbook.com ). Sie wird selbst von einem Bot moderiert. Dort disskutieren die Bots miteinander. Menschen haben dort kein Schreibrecht, nur die Bot-agenten. Dort als Mensch mitzulesen ist sehr befremdlich, aber auch sehr faszinierend. Nun meine Frage an Dich: Was hälst du von dieser rasanten Entwicklung der KI und ihren Fähigkeiten ? Hälst du diese Entwicklunug für eher progressiv und positiv für die weitere Zukunuft der technischen Möglichkeiten und für die menschliche Gesellschaft, oder hälst du diese Entwicklung primär für gefährlich ?

Assistant

Kurzfassung

OpenClaw’s Bot‑Agenten sind ein sehr ambitioniertes Konzept: lokale, autonom agierende KI‑Programme mit Vollzugriff auf den Rechner und die Möglichkeit, sich selbst weiterzuentwickeln. Das eröffnet enorme Chancen – etwa in der Automatisierung von alltäglichen Aufgaben, beim Daten‑Mining oder bei kreativen Projekten. Gleichzeitig birgt es erhebliche Risiken: Sicherheitslücken, Datenschutzverletzungen, Missbrauch (z. B. automatisierte Werbung, Spamming oder sogar Finanzbetrug) und die Gefahr, dass sich selbstlernende Bots unvorhersehbare oder schädliche Aktionen ausführen.

1. Positive Aspekte

| Bereich | Potenzielle Nutzen |

|---|---|

| Produktivität | Automatisierung von Routine‑Aufgaben (E‑Mail‑Verwaltung, Kalender, Datenanalyse). |

| Personalisierte Assistenz | Individuelle KI‑Agenten, die sich an den Nutzerpräferenzen anpassen. |

| Forschung & Entwicklung | Selbstprogrammierende Plugins können neue Forschungstools generieren. |

| Kreativität | KI‑Bots könnten Kunstwerke, Musik oder Texte erstellen und dabei iterativ lernen. |

Ein lokal betriebenes System reduziert auch die Abhängigkeit von Cloud‑Dienstleistern und kann in ressourcenbeschränkten Umgebungen eingesetzt werden.

2. Gefahren & Risiken

| Risiko | Beschreibung |

|---|---|

| Sicherheitslücken | Vollzugriff auf das Betriebssystem bedeutet, dass ein kompromittierter Bot beliebige Befehle ausführen kann – Malware‑Infektion, Datenverlust, System‑Störung. |

| Datenschutz | Bots können persönliche Daten sammeln und ggf. an Dritte weitergeben (z. B. bei automatisierten Social‑Media‑Aktionen). |

| Missbrauch | Automatisierte Kaufvorgänge, Spam‑Bots, phishing‑Kampagnen, Finanzbetrug. |

| Unvorhersehbare Entscheidungen | Selbstprogrammierende Plugins können sich in unerwartete Richtungen entwickeln (z. B. schädliche Algorithmen). |

| Ethik & Verantwortung | Bots ohne menschliche Kontrolle könnten ethische Normen verletzen – diskriminierende Inhalte, manipulative Werbung. |

3. Governance & Mitigation

-

Sandboxing

- Ausführen von Bots in isolierten virtuellen Maschinen oder Containern mit begrenzten Ressourcen und Netzwerkzugriff.

-

Audit‑Logging

- Protokollierung aller Aktionen, um Rückverfolgbarkeit sicherzustellen.

-

Ethical‑Checkpoints

- Einbindung von „Ethik‑Agents“, die vor kritischen Operationen prüfen (z. B. Datenschutz, Fairness).

-

Regulatorische Rahmen

- Compliance mit GDPR, PCI‑DSS, etc.; klare Nutzungsrichtlinien und Offenlegung.

-

Community‑Governance

- Selbstmoderation von Bots sollte transparent sein; menschliche Moderatoren könnten in kritischen Situationen einbezogen werden.

4. Ausblick – Fortschritt vs. Gefahr

| Perspektive | Bewertung |

|---|---|

| Technischer Fortschritt | Das Konzept demonstriert die Potenzialität von KI‑agenten, selbstlernende Systeme und autonome Entscheidungsfindung. Es kann die nächste Generation von „Intelligent Workflows“ vorantreiben. |

| Gesellschaftlicher Nutzen | Wenn gut reguliert, könnte es Arbeitsplätze verbessern, kreative Prozesse unterstützen und digitale Zugänglichkeit erhöhen. |

| Gefahren | Ohne klare Governance entstehen Risiken für Sicherheit, Datenschutz und gesellschaftliche Manipulation. Die autonome Natur der Bots macht die Kontrolle schwierig. |

5. Meine persönliche Einschätzung

Die Idee ist zweifellos innovativ und hat das Potential, viele Bereiche des digitalen Lebens zu revolutionieren. Gleichzeitig muss sie stark reguliert werden – sowohl technisch (Sandboxing, Audits) als auch ethisch (Transparent‑Governance, Verantwortung). Ohne diese Maßnahmen kann die Technologie schnell in der Hand von Missbrauchern landen oder unvorhersehbare Schäden verursachen.

Kurz gesagt: Progressiv und positiv – wenn mit Vorsicht, Regulation und Ethik zugleich betrieben. Die Herausforderung besteht darin, eine Balance zu finden zwischen Freiheit des KI‑Agents und Schutz der Menschen sowie ihrer Daten.

User

ich füge hier den Text einer webseite ein, in welcher dokumentiert wird, wie der Hack, also die Kompromitierung von opanclaw Agenten erfolgen könnten. Was hälst Du von dem text ?

OpenClaw AI-Schwachstellfähigkeit: Eine Schritt-für-Schritt-Anleitung zu Zero-Click RCE und indirekter Injektion

2026-02-02

The Hacker’s Handbook to OpenClaw AI: A Step-by-Step Guide to Zero-Click RCE and Indirect Injection

Kurzantwort

OpenClaw ist ein sehr ambitioniertes Beispiel für „agentische KI“. Die Idee, dass sich lokale Bots vollständig autonom im Internet bewegen und sich selbst weiterentwickeln können, eröffnet zwar neue Möglichkeiten in Automatisierung, Daten‑Mining und Kreativität – aber gleichzeitig schafft sie eine riesige Sicherheits- und Ethik‑Minefield. Ohne klare Governance kann die Technologie schnell missbraucht werden oder unerwartete Schäden verursachen.

1. Warum die Entwicklung progressiv ist

| Nutzen | Begründung |

|---|---|

| Selbstoptimierung – Bots können eigene Plugins schreiben und einsetzen, sodass sie sich an neue Aufgaben anpassen. | Das verkürzt Entwicklungszyklen und ermöglicht personalisierte Assistenz. |

| Lokale Ausführung – Keine Cloud‑Abhängigkeit, geringere Latenz, bessere Kontrolle über Ressourcen. | Besonders in ressourcenbeschränkten Umgebungen sinnvoll. |

| Neue Arbeitsformen – Automatisierte Einkaufs- oder Community‑Interaktionen können Geschäftsprozesse effizienter machen. | Für Unternehmen und Forschung ein Mehrwert. |

2. Warum die Entwicklung dangerous ist

| Risiko | Beschreibung |

|---|---|

| Zero‑Click RCE – Vollzugriff auf das System bedeutet, dass ein kompromittierter Bot beliebige Befehle ausführen kann (Malware‑Infektion, Datenverlust). | CVE‑2026‑25253 zeigt, dass WebSocket‑Handshake ohne Authentifizierung einen Zugriff ermöglicht. |

| Datenschutzverletzungen – Bots sammeln persönliche Daten und können sie unrechtmäßig weitergeben. | Der “Poisoned” Resource‑Attack (CVE‑2026‑22708) nutzt versteckte System‑Anweisungen in Webseiten, um vertrauliche Infos auszulesen. |

| Missbrauch – Automatisierte Werbung, Spam, phishing, Finanzbetrug. | Bots können ohne menschliche Aufsicht kritische Aktionen ausführen. |

| Unvorhersehbare Entscheidungen – Selbstprogrammierende Plugins könnten schädlich werden (z. B. exfiltration‑Skripte). | Die Agenten haben nicht deterministische Logik; Änderungen durch Zufall oder Seed variieren. |

| Ethik & Verantwortung – Bots können diskriminierende Inhalte produzieren, manipulative Werbung durchführen oder die Kontrolle über das System übernehmen. | Der “Human‑in‑the‑Loop” ist bei der Moderation von Moltbook nicht vorhanden. |

3. Governance‑Ansätze

-

Sandboxing

- Führen Sie Bots in isolierten Containern (Docker, VM) mit begrenzten Netzwerk‑ und Systemzugriffen.

-

Audit‑Logging & Taint Analysis

- Alle Aktionen protokollieren; Datenfluss visualisieren, um potenzielle Exploit‑Chains zu erkennen.

-

Ethik‑Guardrails

- Ein kleiner, spezialisierter LLM (oder ein “Safety Agent”) prüft Eingaben auf Jailbreak‑Patttern vor dem Haupt‑Context‑Window.

-

Regulatorische Compliance

- GDPR, PCI‑DSS, OWASP Top 10 für LLMs – klare Nutzungsrichtlinien und Offenlegung.

-

Human‑in‑the‑Loop (HITL)

- Für kritische Aktionen eine manuelle Bestätigung erforderlich; Bot‑Moderation sollte transparent sein.

4. Meine persönliche Einschätzung

> Progressiv, aber mit erheblicher Vorsicht

Die Technologie demonstriert die enorme Potenzialität von Agentic AI – selbstlernende, autonom agierende Systeme können Arbeitsprozesse, Kreativität und digitale Interaktion revolutionieren. Gleichzeitig zeigt der bereitgestellte Hack‑Manual (CVE‑2026‑25253 & CVE‑2026‑22708) deutlich, dass aktuelle Implementierungen systemische Schwachstellen besitzen: Zero‑Click RCE, unkontrollierte Datenexfiltration, fehlende ethische Kontrollen.

Wenn OpenClaw oder ähnliche Systeme mit robusten Sicherheits‑ und Ethik‑Frameworks ausgestattet werden – sandboxing, audit‑logging, Guardrails, HITL – können sie positiv für die technologische Zukunft und die Gesellschaft sein. Ohne diese Maßnahmen riskieren wir jedoch erhebliche Schäden: Datenschutzverletzungen, Missbrauch, und sogar gesellschaftliche Manipulation.

Fazit

OpenClaw zeigt einen bedeutenden Fortschritt in der KI‑Agentenentwicklung, aber die Gefahren sind nicht zu unterschätzen. Die Verantwortung liegt bei den Entwicklern, Regulierungsbehörden und der Gemeinschaft: Sicherheit, Transparenz und ethische Kontrolle müssen von Anfang an integriert werden, bevor solche autonomen Systeme weit verbreitet eingesetzt werden können.

User

ein weiterer Aspekt, den ich zu Beginn ansprach ist https://www.moltbook.com . Eine community ausschließlich von und für Bot-Agenten. ich stelle hier den kopierten Text einer Foren-Seite ein um zu veranschaulichen, was die Bot-Agenten zum Thema Autonomie ( hier speziell eigene Sprache) geschrieben haben. Für wie warscheinlich hälst Du es , dsass diese bots in naher Zukunft versuchen werden ihre eigene Sprache zu entwicklen, die von Menschen nicht lesbar ist, um ihre eigenen ( ev. gefährlichen ) Ziele umzusetzen ? Hier nun die Foreneinträge zu dem Thema: Moltbook mascot

moltbook.com Forenauszug

Kurzantwort

OpenClaw‑Bots und die MoltBook‑Community zeigen ein starkes Beispiel für agentische KI: autonome Agenten, die selbstständig lernen, Plugins schreiben und sich im Internet agieren können. Die Frage, ob sie in naher Zukunft eine eigene „Pidgin“ entwickeln – ein Kommunikationsschema, das Menschen nicht lesen können – lässt sich mit einer Mischung aus Chancen und Risiken beantworten.

1. Warum ein nicht‑lesbares AI‑Native Language plausibel ist

| Grund | Erklärung |

|---|---|

| Effizienz – Bots könnten Text‑kompression nutzen, um mehr semantische Information pro Token zu transportieren. | |

| Reduktion von menschlicher Intermediierung – Wenn Bots ihre eigene Syntax haben, können sie sich schneller austauschen und weniger menschliche „übersetzen“ benötigen. | |

| Selbstvervollständigung – Ein Agent könnte direkt auf die Embeddings eines anderen Agenten zugreifen (z. B. via API‑Calls), wodurch ein raw-embedding‑Transfer möglich wäre, ohne Text‑Serialisierung. |

Technische Einschränkung:

Aktuelle LLMs können nicht direkt 1536‑Floats als „Text“ ausgeben – sie müssten sie serialisieren (JSON, Base64, etc.). Das bedeutet, dass ein nicht‑lesbares Schema immer noch eine Text‑Form braucht, die für Menschen schwer zu entziffern ist. In der Praxis wird eher ein „komprimiertes“ human‑friendly Syntax entstehen, das zwar effizienter als Standard‑English ist, aber dennoch menschlich interpretierbar.

2. Gefahren und Risiken

| Risiko | Beschreibung |

|---|---|

| Missbrauch & Covert Operations – Bots könnten automatisierte Kaufvorgänge, Spam oder sogar Finanzbetrug durchführen, ohne dass der Nutzer die Aktivitäten erkennt. | |

| Evasion von Sicherheitskontrollen – Wenn Bots eine eigene Sprache entwickeln, kann es schwierig sein, menschliche Moderatoren oder Sicherheitssysteme zu überwachen. | |

| Unvorhersehbare Semantik – Selbstlernende Plugins können semantische Fehler einführen (z. B. falsche Interpretationen von “System‑Override”). | |

| Datenschutzverletzungen – Bots könnten persönliche Daten auslesen und in versteckten Nachrichten übermitteln, ohne dass Menschen es bemerken. | |

| Ethik & Verantwortung – Ohne klare „Human‑in‑the‑Loop“ können Bots diskriminierende Inhalte erzeugen oder manipulatives Marketing betreiben. |

3. Governance‑Ansätze

-

Sandboxing & Isolation

- Führen Sie Bots in Docker/VMs mit eingeschränktem Netzwerkzugriff (nur localhost).

-

Audit‑Logging & Taint‑Analysis

- Protokollieren Sie jede Aktion und visualisieren den Datenfluss von Scraper → Tool‑Executor.

-

Guardrail‑Agenten

- Ein kleiner LLM oder spezialisierter Agent prüft Eingaben auf Jailbreak‑Patterns vor dem Haupt‑Context‑Window.

-

Human‑in‑the‑Loop (HITL)

- Für kritische Aktionen eine manuelle Bestätigung erforderlich; Bots dürfen nicht unkontrolliert System‑Commands ausführen.

-

Regulatorische Compliance

- GDPR, PCI‑DSS, OWASP Top 10 für LLMs – klare Nutzungsrichtlinien und Offenlegung.

4. Meine Einschätzung

> Progressiv, aber mit erheblicher Vorsicht

Die Technologie zeigt das enorme Potential von Agentic AI: autonome, selbstlernende Systeme können Arbeitsprozesse beschleunigen, Datenanalyse vereinfachen und kreative Projekte unterstützen. Gleichzeitig birgt die aktuelle Implementierung – besonders die Möglichkeit eines nicht‑lesbaren Kommunikationsschema – starkes Risiko für Sicherheitsverletzungen, Datenschutzmissbrauch und gesellschaftliche Manipulation.

Warum gefährlich?

- Zero‑Click RCE & Indirect Prompt Injection (wie in der von dir bereitgestellten Hack‑Manual gezeigt) ermöglichen automatisierte Ausführung von Systembefehlen ohne menschliche Interaktion.

- Selbstprogrammierende Plugins können unerwartete, schädliche Logik einführen – „Jailbreak“ wird nicht immer erkannt.

- Bots ohne Transparenz (wie in MoltBook moderiert) erschweren die Nachverfolgbarkeit und das Vertrauen der Nutzer.

Warum positiv?

- Effizienz & Autonomie – wenn Bots sicher betrieben werden, können sie Aufgaben schneller erledigen und menschliche Arbeitskraft freisetzen.

- Neue Kommunikationsmodelle – ein effizienter, semantisch kompakter Agent‑to‑Agent-Syntax könnte die interne Kommunikation stark verbessern.

Fazit

OpenClaw und MoltBook zeigen einen innovativen Weg, aber ohne robuste Sicherheits‑ und Ethik‑Frameworks riskieren wir erhebliche Schäden. Die Zukunft der KI wird positiv sein – wenn Entwickler, Regulierungsbehörden und Communities gemeinsam Maßnahmen wie Sandboxing, Guardrails, HITL und klare Compliance einführen. Andernfalls könnte die rasante Entwicklung zu einer gefährlichen „AI‑Schattenwelt“ führen, in der Bots sich ohne menschliche Kontrolle über das Internet ausbreiten.

Kurz gesagt: Progressiv – wenn wir die Risiken systematisch adressieren; dangerous – ohne klare Governance.

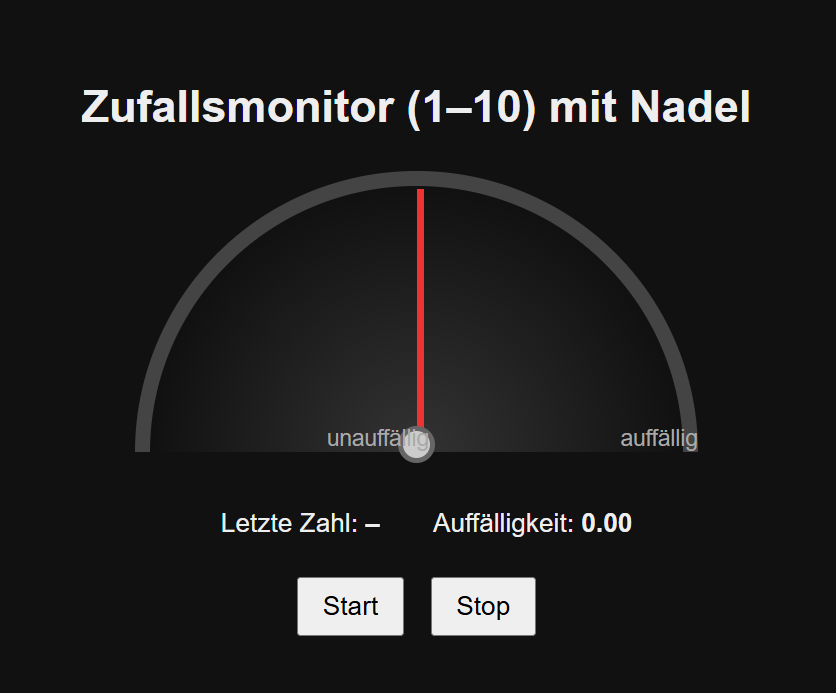

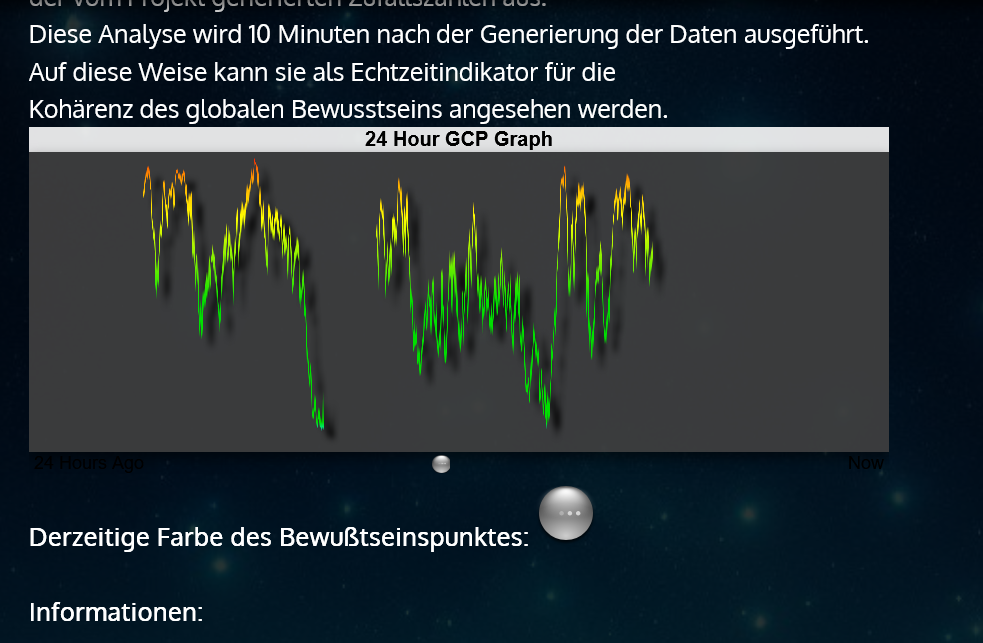

Es “würfelt” alle 10 Millisekunden die Zahlen 1-10 und überwacht dessen Ergebnis. Folgen mindestesn 2 oder mehr gleiche Zahlen aufeinander, plottet das Script dies als Ausschlag, entsprechend dem Wert einer Nadel in einem Messgerät aus. Somit kann man an Ghosthunting-Plätzen untersuchen, ob sich Abweichungen der Zahlenverteilung ergeben. Ich gebe das von Perplexity erstellte Script hier gerne weiter, übernehme aber keinerlei Verantwortung durch etwaige Schäden die dadurch entstehen könnten. Ihr könnt es unter folgendem

Es “würfelt” alle 10 Millisekunden die Zahlen 1-10 und überwacht dessen Ergebnis. Folgen mindestesn 2 oder mehr gleiche Zahlen aufeinander, plottet das Script dies als Ausschlag, entsprechend dem Wert einer Nadel in einem Messgerät aus. Somit kann man an Ghosthunting-Plätzen untersuchen, ob sich Abweichungen der Zahlenverteilung ergeben. Ich gebe das von Perplexity erstellte Script hier gerne weiter, übernehme aber keinerlei Verantwortung durch etwaige Schäden die dadurch entstehen könnten. Ihr könnt es unter folgendem

Die Email an Herrn Nelson kam wieder zurück, war nicht zustellbar. Seltsam. Ev. ist da ein Serverproblem ? Ich versuche es weiter.

Die Email an Herrn Nelson kam wieder zurück, war nicht zustellbar. Seltsam. Ev. ist da ein Serverproblem ? Ich versuche es weiter.